L’intelligenza artificiale non è solo tecnologia. È linguaggio, cultura, interpretazione del mondo. Ogni scelta algoritmica riflette ciò che riteniamo importante e ciò che vogliamo escludere. Come tutte le innovazioni suscita entusiasmi e timori, ma la storia mostra che il vero rischio non è il cambiamento ma la mancanza di consapevolezza. Perché ogni nuova tecnologia all’inizio rompe le abitudini e appare come una “minaccia”, ma poi trasforma il modo in cui viviamo e produciamo cultura.

Proprio per questo, è fondamentale interrogarsi sui bias insiti nei sistemi di AI. Questi «pregiudizi» – spesso invisibili, che derivano dai dati, dai contesti culturali e dalle scelte di chi progetta gli algoritmi – rischiano di amplificare disuguaglianze sociali e stereotipi storici. Comprendere e gestire i bias non è solo una questione tecnica. È un tema culturale ed etico, che riguarda il modo in cui vogliamo che la tecnologia rifletta la nostra società.

La fotografia è un esempio emblematico. Nata nella prima metà dell’Ottocento, suscitò forti resistenze culturali. Pittori e critici la consideravano pericolosa, una minaccia per l’arte, la creatività e il valore dell’intervento umano. La macchina sembrava sottrarre spazio al talento, riducendo la creazione dell’immagine a un “semplice” processo meccanico. Un “banale” click. Col tempo, però, questa lettura si è rivelata infondata. La fotografia non ha distrutto la pittura e né cancellato la creatività. Anzi, ha generato nuovi linguaggi, estetiche e professionalità. E con la fotografia “nel digitale” è stato lo stesso. Si temevano immagini meno “autentiche”, perdita di competenze, svalutazione del mestiere. Eppure, la tecnologia non ha cancellato la fotografia. Ne ha ampliato usi, contesti e possibilità. Allo stesso modo, il personal computer, inizialmente percepito come “complicazione inutile”, è diventato ben presto parte integrante della vita e del lavoro.

Questi esempi mostrano che la paura iniziale verso una nuova tecnologia non implica necessariamente un apporto dannoso della stessa. Al contrario, il concetto di “distruzione creativa”, teorizzato da Joseph Schumpeter nel 1942, descrive un processo naturale: l’innovazione tende a sostituire vecchie strutture con soluzioni migliori, ma è preceduta da un “periodo di adattamento”, spesso vissuto come perdita o disorientamento. La cosiddetta “paura verso il nuovo”, che non significa la tecnologia sia nociva; è semplicemente una reazione naturale al cambiamento. Il vero rischio, infatti, consiste nell’ignorare come funziona e come viene utilizzata quell’innovazione. Come evidenziato da studi sull’economia dell’innovazione (Brynjolfsson & McAfee, The Second Machine Age e Joel Mokyr, The Lever of Riches e A Culture of Growth), l’impatto delle tecnologie dirompenti non può essere valutato nel breve periodo: molte innovazioni, inizialmente percepite come minacce, mostrano effetti positivi nel lungo termine, dopo fasi di adattamento istituzionale, sociale ed economico.

Lo stesso vale per l’intelligenza artificiale: conoscerne il “contesto” di nascita, i processi costruttivi e di impostazione e gli insiti aspetti positivi e negativi è fondamentale per usarla al meglio e guidarne lo sviluppo in modo consapevole.

Il termine “intelligenza artificiale” nasce ufficialmente nel 1956, durante la conferenza di Dartmouth. John McCarthy, Marvin Minsky, Nathaniel Rochester e Claude Shannon proposero di esplorare la possibilità che le macchine potessero simulare ogni aspetto dell’apprendimento e dell’intelligenza umana. Già in questo atto simbolico emergeva un’idea incisiva: legare la parola “intelligenza”, carica di storia e significati culturali, a strumenti matematici e informatici.

Negli anni successivi, l’IA si sviluppò seguendo due approcci principali: da un lato i sistemi simbolici – basati su regole logiche e rappresentazioni esplicite della conoscenza, dall’altro i modelli statistici e probabilistici – che permettevano di trattare “incertezze” e grandi quantità di dati. Ma questa evoluzione non è avvenuta in un contesto “neutro”: la ricerca era infatti prevalentemente maschile e occidentale, e le scelte culturali e sociali dei ricercatori hanno contribuito a plasmare le definizioni operative di “intelligenza” adottate nei sistemi.

Il concetto di “intelligenza” è poi cambiato profondamente nel tempo. All’inizio era legato al contesto concreto: capire situazioni quotidiane, adattarsi, risolvere problemi pratici. Con lo sviluppo dell’informatica e della psicologia cognitiva negli anni ’50, però, “l’intelligenza” è stata interpretata in modo più astratto e misurabile. Ci si concentrò su abilità cognitive osservabili e quantificabili, come memoria, ragionamento logico e risoluzione di problemi standardizzati. In altre parole, la definizione passò da una visione ampia e situata, che includeva creatività ed esperienza pratica, a un modello più tecnico, pensato per costruire macchine, ma limitato rispetto alla complessità della mente umana.

La cosiddetta “rivoluzione cognitiva” degli anni Cinquanta contribuì a questa trasformazione – grazie a figure come George Miller, Noam Chomsky, Allen Newell e Herbert Simon, che fondarono un approccio interdisciplinare tra psicologia, linguistica, informatica e neuroscienze.

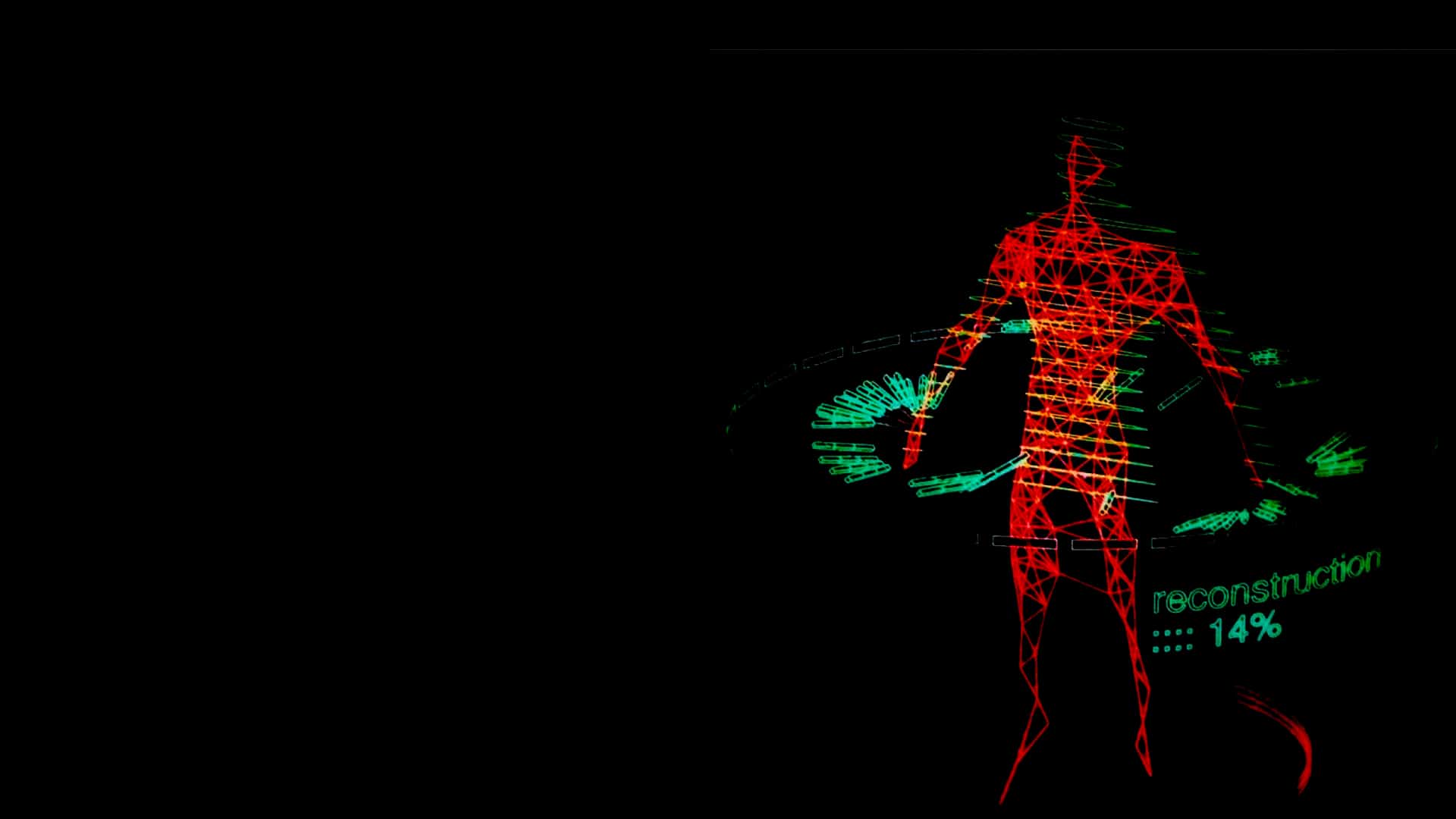

Negli anni 2000 e 2010, con l’avvento del big data e del deep learning, l’IA iniziò a permeare quasi tutti gli ambiti della società: dalla medicina alla finanza, dai servizi pubblici alle piattaforme digitali. L’idea di una “intelligenza” misurabile e calcolabile, però, portava con sé limiti intrinseci: le macchine riflettono solo ciò che è rappresentato nei dati e nei modelli, escludendo esperienze e conoscenze non codificate. E questo è il terreno in cui i bias emergono in modo sistemico.

I bias, infatti, derivano dalle scelte umane, dai dati e dai contesti culturali. Negli anni ’60-’70, i primi sistemi simbolici presupponevano la neutralità delle macchine, ma ogni regola rifletteva le decisioni dei progettisti. Amos Tversky e Daniel Kahneman negli anni ’70 mostrarono come le distorsioni cognitive umane potessero trasferirsi ai sistemi digitali. E con l’avvento del machine learning, questi pregiudizi si amplificano: Caliskan, Bryson e Narayanan nel 2016 hanno dimostrato come i word embedding producono discriminazioni di genere, razza e professione, mentre negli anni 2010 sistemi di riconoscimento facciale e selezione automatica dei CV hanno mostrato penalizzazioni concrete verso donne e persone con pelle scura – come documentato in Gender Shades di Buolamwini e Gebru.

Oggi, infatti, i bias non sono più “solo” un errore tecnico, ma un problema sociale e culturale. Gruppi vulnerabili rischiano discriminazioni in ambito lavorativo, assicurativo, sanitario e giudiziario. La consapevolezza di questi rischi ha portato alla nascita di iniziative globali come Black in AI e Algorithmic Justice League, che promuovono la ricerca critica, la trasparenza degli algoritmi e la sensibilizzazione pubblica sul tema. Allo stesso tempo, organismi internazionali come l’UE e l’OCSE hanno elaborato linee guida etiche per ridurre le discriminazioni sistemiche e promuovere la “fairness” nei sistemi di intelligenza artificiale.

Ma correggere algoritmi e dati non basta: l’IA riflette chi la progetta e la utilizza.

Un approccio teorico interessante arriva sí da Marshall McLuhan, che negli anni ’60 osservava come “il mezzo sia il messaggio”, ma – alla luce dell’attuale evoluzione tecnologica – non basta più limitarsi al mezzo: chi lo progetta e lo utilizza ha infatti un ruolo determinante nel definire il contenuto e la forma del messaggio. In questo senso, Harold Innis parlava del “bias del mezzo”, sottolineando che ogni tecnologia favorisce certe forme di comunicazione rispetto ad altre, ma che la scelta di cosa trasmettere e come farlo resta nelle mani degli esseri umani. Anche Friedrich Kittler, più recentemente, ha evidenziato che le tecnologie mediali strutturano le possibilità del discorso, ma non lo determinano in modo assoluto: il senso e l’impatto dei messaggi emergono dall’interazione tra strumenti e decisioni di chi li produce.

Ecco perché formare persone critiche e consapevoli è essenziale, non solo per capire come funziona l’IA, ma per decidere come e con quali valori usarla. Solo così la tecnologia può diventare uno strumento inclusivo e “potente”, capace di riflettere il meglio dell’esperienza umana, senza perpetuare all’infinito i pregiudizi del passato.